La barriera della memoria

20 June 2019 | Scritto da La redazione

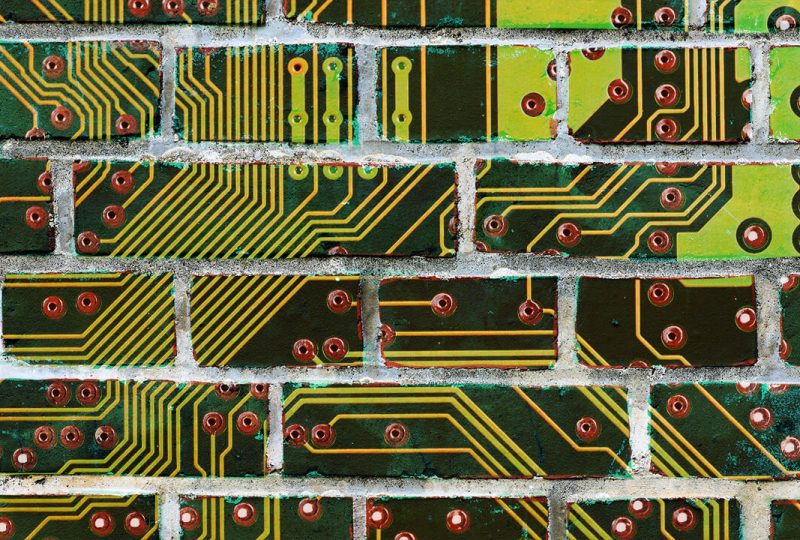

Un muro rallenta le performance dei computer, una barriera non fisica ma computazionale.

Per chi è un appassionato del mondo dell’informatica il concetto non sarà nuovo, ma probabilmente chiunque usi un computer si è imbattuto in questo fenomeno pur senza saperlo. Si chiama memory wall, la barriera della memoria, ed è un concetto teorizzato nel 1994 da William Wulf e Sally McKee, due informatici della Virginia University. Una barriera, questa, che porta ad un calo delle performance dei nostri computer – in maniera marginale – e dei supercomputer utilizzati nella ricerca. Si cercando soluzioni e un gruppo di scienziati greci potrebbe essere sulla buona strada per abbattere questo muro e per farlo utilizza la luce.

Il paradosso, nato dalle osservazioni dei trend di sviluppo delle performance dei componenti utilizzati nei computer, indica che le capacità dei processori, i cervelli dei computer che svolgono le operazioni, crescono a una velocità di circa il 55% ogni anno, di contro, le capacità delle RAM – Random Access Memory -, ovvero la memoria a breve termine che viene utilizzata dai processori per eseguire i calcoli, cresce di un misero 9-10% annuo.

Le conseguenze. I due componenti, quindi, crescono a velocità profondamente diverse e divergenti: con il passare del tempo la velocità di calcolo dei processori si allontana sempre di più da quella delle RAM e questo crea un problema non da poco. Dato che i processori devono accedere alla RAM per effettuare le operazioni, non importa quanto i processori siano veloci, se la RAM non tiene il passo l’intero sistema risulta rallentato.

Il problema è ben noto nel mondo dell’informatica e si cercano soluzioni economicamente accessibili che saranno di fondamentale importanza vista l’impennata dei big data e della loro analisi: un ambito sempre più diffuso che ha impatti in moltissimi settori, dallo sviluppo delle intelligenze artificiali alla gestione delle banche dati in campo medico, passando per gli studi sul clima che necessitano di enormi quantità di calcoli per simulare gli andamenti climatici e permetterci di prepararci al meglio alle instabilità meteorologiche che potrebbero caratterizzare gli anni a venire.

Dove si erge il muro. Nei computer che utilizziamo normalmente, quello su cui magari state leggendo questo articolo, il muro non è un grave problema. Le performance richieste per stare su Facebook, guardare l’ultima puntata della nostra serie TV preferita, o giocare ai videogiochi, non risentono in maniera pesante di questo collo di bottiglia che si viene a creare nella comunicazione fra RAM e CPU (il processore). Il muro diventa un problema nei grandi sistemi informatici, nei super computer usati nella ricerca, nell’analisi dei big data e nelle simulazioni. Queste macchine macinano mostruose quantità di dati e, considerato il loro alto consumo energetico, ogni secondo di operazione in porta a un costo più elevato dell’operazione.

Abbattere il muro. Esistono sistemi e algoritmi che, almeno in parte, sono in grado di ridurre il problema, ma il limite computazionale rimane. La ricerca di nuove soluzioni è quindi molto importante, sia dal lato dell’ottimizzazione dei software sia dal lato hardware. Un team di ricerca greco potrebbe essere sulla buona strada grazie allo sviluppo di una RAM ottica, ovvero che utilizza la luce al posto dell’elettricità, che è in grado di raggiungere velocità di 10 gigabits al secondo.

Guarda il video: