Il dilemma etico delle armi autonome

10 December 2019 | Scritto da La redazione

I passi da gigante nei campi della robotica e dell’intelligenza artificiale fanno emergere dilemmi sull'uso e sui rischi di queste tecnologie

La squadra artificieri del Massachussets da diversi mesi utilizza i robot SpotMini della Boston Dynamics nelle loro operazioni. Vengono usati come piattaforme mobili di supporto o per sorvegliare situazioni pericolose. Non è stato reso noto quale livello di autonomia ci fosse dietro le azioni dei robot, se seguissero i dettami del loro algoritmo di intelligenza artificiale per gestire le operazioni o se ci fosse un agente a controllare i loro movimenti, resta il fatto che un certo grado di autonomia del robot fosse presente. E se un giorno fosse il dipartimento di polizia a volere degli SpotMini? E se questi venissero dotati di un’arma? Il discorso etico sulle armi autonome deve partire adesso, prima che la tecnologia possa essere sviluppata in direzioni non desiderabili.

Macchine autonome. Quando parliamo di macchine autonome intendiamo sistemi di intelligenza artificiale, magari applicati alla robotica, in grado di prendere decisioni. Un algoritmo in grado, per esempio, di identificare una determinata immagine di fatto “decide” se ciò che gli viene mostrato sia o meno l’immagine in questione. In un articolo pubblicato di recente su The Conversation, Christoffer Heckman, professore di Computer Science dell’Università di Colorado Boulder, esprime delle considerazioni importanti sulla questione: nel 2010, – sostiene Heckman – gli algoritmi di riconoscimento immagini avevano un tasso di successo del 50% circa, oggi ci aggiriamo attorno all’86%. Questo significa due cose: questi algoritmi migliorano con un tasso esponenziale e diventano sempre più efficaci, inoltre, più aumenta l’efficacia delle macchine, maggiore è la probabilità che l’essere umano venga rimosso dall’equazione. Finché si tratta di riconoscere un’immagine fra tante – prosegue – il problema non sembra grave, ma se la si trattasse di individuare una determinata persona, un sospettato pericoloso magari, l’assenza dell’uomo nel processo potrebbe essere il bordo di una china scivolosa, specialmente se il robot fosse dotato di armi.

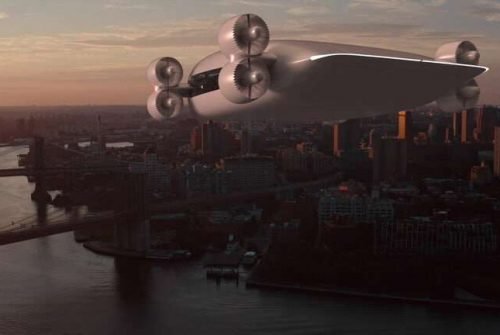

Alla portata di tutti. Lo sviluppo delle macchine autonome corre dunque veloce e sulle ali della rete: internet permette uno scambio rapido e consistente di competenze e tecniche, tale che se una volta era limitato agli addetti ai lavori oggi stanno nascendo piattaforme che tramite tutorial e guide DIY su come sviluppare la propria IA permettono a persone che non hanno alcuna conoscenza informatica di apprendere alcuni degli strumenti per addestrare un sistema autonomo all’avanguardia. Quanto potrebbe diventare difficile quindi per qualsiasi malintenzionato acquisire queste competenze e addestrare un’IA a pilotare un drone armato di esplosivi?

Gestire le armi autonome. La tecnologia alla base di sistemi capaci di selezionare e colpire i bersagli senza l’intervento umano esiste già e lo sviluppo di armi autonome, dal punto di vista tecnico, potrebbe non essere troppo lontano. È essenziale dunque costruire attorno al tema un dibattito collettivo sul loro eventuale divieto. Diversi ricercatori, esperti e studiosi di etica si stanno interrogando sulla questione. Secondo il professor Heckman esistono tre approcci possibili: si potrebbe provare a gestire la cosa attraverso una stretta regolamentazione, ma vista la facilità con cui questi sistemi possono essere sviluppati in proprio l’efficacia di queste misure sarebbe sicuramente limitata.

Un altro approccio potrebbe essere quello dell’autogestione, i ricercatori coinvolti nello sviluppo delle macchine autonome potrebbero incontrarsi e cercare di darsi delle linee guida ma la questione sarebbe delicata, le tecnologie dietro questi dispositivi spesso hanno utilizzi non solo pacifici ma anche estremamente utili.

Ancora, si potrebbe sviluppare un organo che gestisca e soprassieda gli studi e le ricerche sul tema, ma questo significherebbe creare un organismo sovranazionale il cui spazio di azione corrisponderebbe a quello che ciascuno Stato gli fornirebbe.

La comunità scientifica si è già espressa. A prescindere dal possibile approccio la questione rimane di fortissimo interesse per la comunità scientifica: lo scorso febbraio è stata pubblicata una lettera da un gruppo di scienziati che hanno richiesto la messa al bando della ricerca e sviluppo di sistemi d’arma autonoma controllati da intelligenza artificiale. Ciò che è importante, però, è che questo discorso esca dai laboratori e che coinvolga anche chi non si occupa in prima persona di questi temi: il futuro delle macchine autonome è nelle nostre mani, per guidarlo verso il migliore dei futuri possibili bisogna solo far sentire la propria voce.